Los raspadores web escupen lo que parece una sopa de letras a medio digerir.

Bruto.

Uno podría suponer problemas gastrointestinales, pero no es exactamente así.

Los raspadores web procesan los datos en un formato no estructurado, por lo que lo que se obtiene es un documento HTML o cualquier otro desorden.

Introduzca el análisis de datos.

El análisis sintáctico de datos es un método que utilizan los web scrapers para tomar páginas web y convertirlas a un formato más legible. Es un paso esencial en el web scraping porque, de lo contrario, los datos serían difíciles de leer y analizar.

El análisis sintáctico es esencial para leer el lenguaje informático. Como pronto verás, también es esencial para comprender la realidad.

Análisis sintáctico definido

El término análisis sintáctico [de datos] procede del latín pars (orationis), que significa parte de la oración. Puede tener significados ligeramente diferentes en distintas ramas de la lingüística y la informática.

La psicolingüística utiliza este término para referirse a los indicios orales que ayudan a un hablante a interpretar frases hechas. En otro idioma, el término análisis sintáctico también puede significar división o separación.

Vaya, más de lo que quieres saber, ¿verdad?

Todo eso para decir que analizar significa dividir el discurso en partes.

Supongamos que definimos el análisis sintáctico en el lenguaje de la programación informática. (¿He despertado ya su interés?)

En ese caso, se refiere a cómo se lee y procesa una cadena de símbolos, incluidos los caracteres especiales.

El análisis sintáctico tiene distintas definiciones para los lingüistas y los programadores informáticos. Aun así, el consenso general es que significa analizar frases y establecer relaciones semánticas entre ellas. En otras palabras, el análisis sintáctico consiste en filtrar y archivar estructuras de datos.

¿Qué es el análisis sintáctico de datos?

El término análisis sintáctico de datos describe el tratamiento de datos no estructurados y su conversión a un nuevo formato estructurado.

El proceso de análisis está en todas partes. El cerebro analiza continuamente los datos del sistema nervioso.

Pero en lugar de que los programas de ADN analicen el dolor y el placer para promover la generación de vida, los analizadores sintácticos en el contexto de este artículo convierten los datos recibidos de los resultados del web scraping.

(Cue decepción)

However, in both cases, we need to adapt one data format into a form capable of being understood. Whether that’s producing reports from HTML strings or sensory gating.

La estructura de un analizador de datos

El análisis sintáctico de datos suele constar de dos fases esenciales: el análisis léxico y el análisis sintáctico. Estas fases transforman una cadena de datos no estructurados en un árbol de datos cuyas reglas y sintaxis se integran en la estructura del árbol.

Análisis léxico

Lexical analysis in its simplest form assigns a token to each piece of data. The tokens or lexical units include keywords, delimiters, and other identifiers.

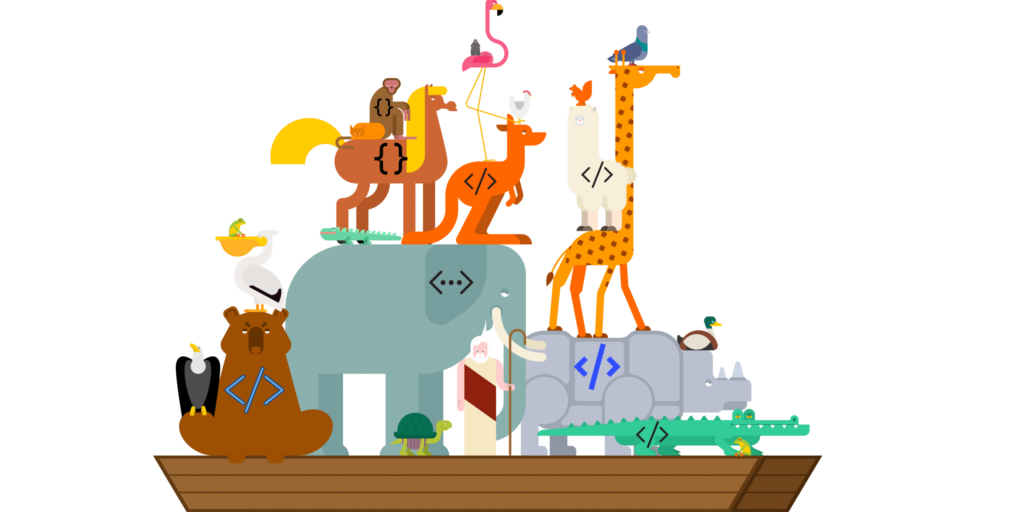

Digamos que tienes una larga fila de criaturas abordando un barco. A medida que pasan por la puerta, cada criatura recibe una ficha. El elefante recibe la "ficha de animal terrestre enorme" y el caimán la "ficha de anfibio peligroso".

Así sabremos dónde colocar a cada criatura en el barco, para que nadie se haga daño en las vacaciones del crucero al sol.

En el mundo del análisis sintáctico de datos, se asignan unidades léxicas a los datos no estructurados. Por ejemplo, una palabra en una cadena HTML recibirá un token de palabra y así sucesivamente. Los tokens irrelevantes contienen elementos como paréntesis, llaves y punto y coma. A continuación, puede organizar los datos por tipo de token.

Como puede ver, el análisis léxico es un paso crucial para obtener datos precisos para el análisis sintáctico.

Y mantener a raya a los caimanes.

Análisis sintáctico

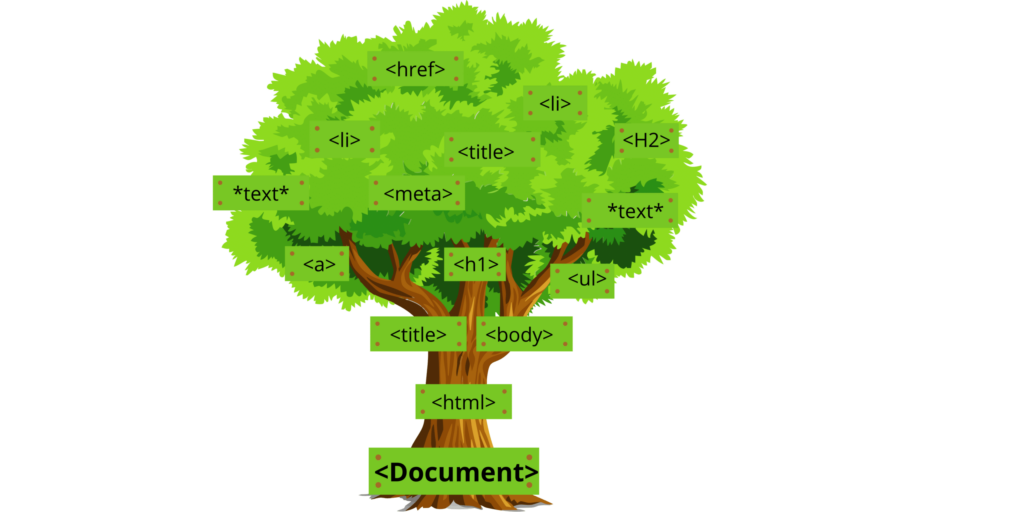

Syntax analysis is the process of constructing a parse tree. If you’re familiar with HTML, then this will be easy for you to understand. For instance, let’s say we parse an HTML web page and create a document object model (DOM). The text between tags becomes child nodes or branches on the parse tree, while attributes become branch properties.

La fase de análisis sintáctico crea estructuras de datos que dan sentido a lo que antes eran simples cadenas de datos. Esta fase también agrupa todos los tokens por tipo, ya sean palabras clave o identificadores como paréntesis, llaves, etcétera. Así, cada token tiene su propio nodo dentro de la estructura más amplia que construye el analizador sintáctico.

Análisis semántico

El análisis semántico es un paso que no está implementado en la mayoría de las herramientas de web scraping. Permite extraer datos de HTML identificando distintas partes de la oración, como sustantivos, verbos y otras funciones.

Pero volvamos al análisis sintáctico de nuestra página web para hablar del análisis semántico. El analizador sintáctico descompondrá cada frase en su forma correcta. Entonces continuará construyendo nodos hasta que alcance la etiqueta final o la llave de cierre '}' - que significa el final de un elemento.

El árbol de análisis sintáctico le mostraría qué elementos están en juego. Por ejemplo, qué palabras componen el contenido de su página web, pero nada sobre la interpretación (semántica), ya que no se asignaron valores durante el análisis sintáctico. Para ello, hay que volver a analizar los elementos de la página web.

Tipos de analizadores de datos

Los analizadores descendentes y ascendentes son dos estrategias diferentes para el análisis sintáctico de datos.

Top-down parsing is a way to understand sentences by looking at the most minor parts and then working your way up. This is called the primordial soup approach. It’s very similar to sentence diagramming, which breaks down the constituents of sentences. One kind of this type of parser is LL parsers.

Bottom-up parsing starts from the end and works its way up, finding the most fundamental parts first. One kind of this type of parser is called LR parsers.

¿Construir o comprar?

Como cocinar macarrones con queso, a veces es más barato hacerlos uno mismo que comprar el producto. Cuando se trata de analizadores de datos, la pregunta no es tan fácil de responder. Hay más cosas a tener en cuenta a la hora de elegir entre construir o comprar herramientas para la extracción de datos. Veamos el potencial y el resultado de ambas opciones con las dos posibilidades disponibles.

Comprar un analizador de datos

La web está llena de tecnologías de análisis sintáctico. Puedes comprar un analizador sintáctico y obtener resultados rápidamente a un precio asequible. El inconveniente de este enfoque es que si quieres que tu software funcione en distintas plataformas o para otros fines, tendrás que comprar más de un producto.

Esto puede resultar costoso con el tiempo y, dependiendo de los objetivos y recursos de su equipo, puede no ser práctico. Existen herramientas de análisis de datos gratuitas y de pago. Aun así, todo depende de las necesidades de tu equipo, así que tenlas en cuenta a la hora de comprar un servicio web en lugar de desarrollar un código personalizado.

Profesionales de la externalización

- La compra de un analizador de datos le da acceso a las tecnologías de análisis de una organización especializada en la extracción de datos. La mayor parte de sus recursos se destinan a la mejora y la eficacia del análisis sintáctico de datos.

- Dispondrá de más tiempo y recursos porque no tendrá que invertir en un equipo ni dedicar tiempo a mantener su propio analizador sintáctico. Hay menos posibilidades de que surjan problemas.

Contras de la externalización

- Es probable que no tenga suficientes oportunidades de personalizar su analizador de datos para satisfacer las necesidades de la empresa.

- El coste de cualquier personalización puede surgir si subcontrata la programación.

Creación de un analizador de datos

Construir tu propio analizador de datos es beneficioso, pero puede consumir demasiada energía y recursos. Sobre todo si necesita un proceso de análisis complejo para analizar grandes estructuras de datos. El desarrollo y el mantenimiento requieren un equipo de desarrollo capaz y experimentado. La última vez que lo comprobé, ¡un científico de datos no es barato!

Construir un analizador de datos requiere habilidades como:

- Procesamiento del lenguaje natural

- Extracción de datos

- Desarrollo web

- Construcción del árbol de análisis sintáctico

Usted o su equipo deberán dominar los lenguajes de programación y las tecnologías de análisis sintáctico.

Profesionales internos

- Los analizadores internos son eficaces porque se pueden personalizar.

- La contratación interna de su analizador de datos le dará un control total sobre el mantenimiento y las actualizaciones.

- Si el análisis sintáctico de datos es un componente importante de su negocio, a la larga le resultará más rentable.

También te beneficias de utilizar tu propio producto en cualquier lugar después de desarrollarlo, lo que es esencial cuando se construyen analizadores de datos frente a la compra de uno. Si compras un analizador, te quedas atrapado en su plataforma, como Google Sheets.

Contras internas

- Mantener, actualizar o probar tu propio analizador sintáctico lleva mucho tiempo. Por ejemplo, para editar y probar tu propio analizador sintáctico necesitarás un servidor capaz de soportar los recursos necesarios.

¿Qué herramientas necesita para el análisis sintáctico de datos?

Si vas a crear un raspador web, necesitarás una biblioteca de análisis de datos con el lenguaje de programación adecuado. Ruby, Python, JavaScript (Node.js), Java y C++ son opciones dependiendo del lenguaje de programación que quieras utilizar para tu proyecto de análisis de datos.

These programming languages work with the web-crawling framework Nokogiri or web frameworks such as Django or Flask in the case of Python.

Or, if you’re going with Ruby, you can choose between Nokigiri and Cheerio, which provides an API that works well alongside Rails web applications.

For Node.js programming, JSoup can be used, while Scrapy is another option for web crawling here too!

Veámoslo más de cerca:

Nokogiri

Nokogiri te permite trabajar con HTML con Ruby. Tiene una API similar a la de otros paquetes de otros lenguajes, que te permite consultar los datos que recuperas del web scraping. Trata cada documento con un cifrado por defecto que añade una capa extra de seguridad. Puedes utilizar Nokogiri con frameworks web como Rails, Sinatra y Titanium.

Hasta luego

Cheerio es una gran opción para el análisis sintáctico de datos Node.js. Proporciona una API que puedes utilizar para explorar y cambiar la estructura de datos de los resultados de tu web scaping. No tiene un renderizado visual, no aplica CSS, ni carga recursos externos como lo haría un navegador. Cheerio tiene muchas ventajas sobre otros frameworks, incluyendo un mejor manejo de lenguajes de marcado rotos que la mayoría de las alternativas, ¡al tiempo que proporciona rápidas velocidades de procesamiento!

JSoup

JSoup permite utilizar datos gráficos HTML a través de una API para recuperar, extraer y manipular URL. Funciona como navegador y como analizador sintáctico de páginas web. Aunque suele ser difícil encontrar otras opciones Java de código abierto, sin duda merece la pena tenerlo en cuenta.

BeautifulSoup

BeautifulSoup is a Python library to pull data from HTML and XML files. This web-crawling framework is so helpful when it comes to parsing web data. It’s compatible with web frameworks such as Django and Flask.

Chatarra

Scrapy is a web crawling framework written in Python available through PyPI. It makes it very simple to write web crawlers while being powerful enough to do custom tasks. Scrapy can also be used as its own web scraping library.

Parsimonioso

The Parsimonious library uses the parsing expression grammar (PEG). You can use this parser in Python or Ruby on Rails applications. PEGs are commonly found in some web frameworks and parsers due to their simplicity compared with context-free grammars. But they have limitations when trying to parse languages without whitespaces between some words like C++ code samples.

LXML

Lxml is another Python XML parser that allows you to traverse the structure of data from web pages. It also includes many extra features for HTML parsing and XPath queries, which can help when scraping web results. It’s been used in many projects by NASA and Spotify, so its popularity certainly speaks for itself!

Deberías inspirarte en estas opciones antes de decidir cuál funcionará mejor para tu equipo.

Evitar los bloqueos del web scraping

It’s a common problem to get blocked web scraping. Some people simply do not want the load and risk that comes with robot visitors. (Pesky bots!) You can learn more about it here.

The way forward is to use rotating residential proxies. Many web scraping APIs include them, but you should be familiar with proxies if you plan to build your own parser.

This article will tell you all about residential proxies and how you can use them for data extraction.

Casos prácticos de análisis sintáctico de datos

Ahora ya conoces las ventajas de utilizar un analizador sintáctico para convertir páginas web a un formato fácil de leer. Veamos algunos casos de uso que podrían ayudar a tu equipo.

Seguridad web

Es posible que desee mantener los datos a salvo de los piratas informáticos cifrando cualquier información confidencial de sus archivos de datos antes de enviarlos por Internet o almacenarlos en dispositivos. Puedes analizar los registros de datos y buscar rastros de malware u otros virus.

Desarrollo web

La web es cada vez más compleja, por lo que es importante analizar los datos y utilizar herramientas de registro para comprender cómo interactúan los usuarios con las páginas web. El sector del desarrollo web seguirá creciendo a medida que las aplicaciones móviles se conviertan en una parte importante de nuestras vidas.

Extracción de datos

El análisis sintáctico de datos es una práctica crucial para la extracción de datos. El web scraping puede llevar mucho tiempo, y es importante analizar los datos lo antes posible para que el proyecto no se salga de los plazos previstos. Para cualquier proyecto de desarrollo web o de extracción de datos, necesitarás saber cómo utilizar correctamente un analizador de datos.

Análisis de inversiones

Los inversores pueden explotar eficazmente la agregación de datos para tomar mejores decisiones empresariales. Inversores, fondos de cobertura u otros que evalúan empresas emergentes, predicen beneficios e incluso controlan el sentimiento social dependen de técnicas sólidas de extracción de datos.

Web scrapers and parsing tools make it fast and efficient. They optimize workflow and allow you to direct resources elsewhere or focus on more deep data analysis such as equity research and competitive analysis. For more information about web scraping tools – click here.

Análisis de registros

Registry analysis is an instrumental and powerful technique in searching for malware in an image. In addition to persistence mechanisms, malware often has additional artifacts that you can look for. These artifacts include values under the MUICache key, prefetch files, the Dr. Watson data files, and other objects. These and different types of malware can provide indications in such cases that antivirus programs cannot detect.

Inmobiliario

Un analizador puede beneficiar a una empresa inmobiliaria mediante datos de contacto, direcciones de propiedades, datos de flujo de caja y fuentes de clientes potenciales.

Finanzas y contabilidad

La explotación de datos se utiliza para analizar la puntuación crediticia y los datos de la cartera de inversiones y obtener una mejor perspectiva de las interacciones de los clientes con otros usuarios. Las empresas financieras utilizan el análisis sintáctico para determinar la tasa y el periodo de amortización de la deuda tras extraer los datos.

También puede utilizar el análisis sintáctico de datos con fines de investigación para determinar los tipos de interés, la tasa de rendimiento de los pagos de préstamos y el tipo de interés de los depósitos bancarios.

Optimización del flujo de trabajo empresarial

Las empresas utilizan analizadores de datos para convertir datos no estructurados en información útil. La extracción de datos permite a las empresas optimizar los flujos de trabajo y sacar partido de un análisis exhaustivo de los datos. El análisis sintáctico puede utilizarse en publicidad, marketing social, gestión de redes sociales y otras aplicaciones empresariales.

Envíos y logística

Las empresas que ofrecen bienes y servicios en Internet utilizan el raspado de datos para extraer detalles de facturación. Utilizan analizadores sintácticos para organizar las etiquetas de envío y verificar que se ha corregido el formato.

Inteligencia artificial

Natural Language Processing (NLP) is at the forefront of artificial intelligence and machine learning. It’s an avenue of data parsing that helps computers understand human language.

Hay muchos más usos. A medida que nos adentramos en la era digital, la diferencia entre el código informático y los datos orgánicos es cada vez menor.

For more information about web scraping and data parsing – visit more of our blog.