Устали от копирования и вставки? Узнайте о самых простых способах извлечения изображений из Интернета.

Если вам нужна только заставка или фоновая картинка, то веб-скрапинг может оказаться излишним. Но это все равно навык, который переходит во многие другие области. Так что оставайтесь здесь.

Мы начнем с расширений для браузеров, рассмотрим программы для извлечения изображений, а затем перейдем к инструментам веб-скрапинга.

Что такое скраппинг изображений?

скрапинг изображений - это простое получение URL-адреса изображения с веб-сайта и помещение его в базу данных для последующего использования.

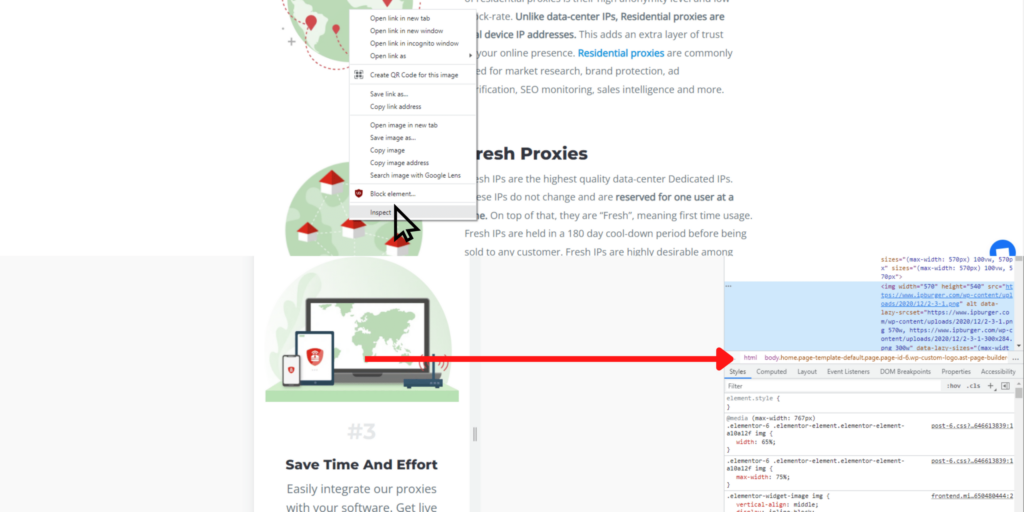

Например, если вы хотите сохранить рекламные изображения с веб-страницы, достаточно скопировать HTML-файл сайта в электронную таблицу. Для этого достаточно щелкнуть правой кнопкой мыши на изображении и выбрать пункт Inspect. Если вы используете Chrome, то увидите всплывающие инструменты разработчика и сосредоточитесь на строке HTML для изображения.

Автоматизация этого процесса - это то, что большинство людей называют скраппингом изображений.

Зачем автоматизировать поиск изображений?

Если вам нужно взять несколько изображений с сайта, к которому у вас нет доступа администратора, вы можете просто "сохранить как" конкретное изображение, и файлы окажутся на вашем компьютере.

Однако если вам нужны сотни или тысячи изображений с нескольких URL-адресов, "сохранить как" - это пустая трата времени. Вот тут-то и приходит на помощь скриптинг изображений. Вместо того чтобы нажимать на одни и те же кнопки снова и снова, можно использовать скрипты, которые автоматизируют этот процесс, сокращая тысячи нажатий до нескольких.

Типы скреперов изображений.

Существует несколько способов сканирования изображений. Несмотря на то, что все они быстрее и проще, чем вручную сохранять каждое изображение по одному на компьютере, они работают по-разному.

Поэтому сначала необходимо определить каждый тип метода скраппинга.

Расширения для браузеров.

При использовании расширений для браузеров необходимо установить плагин и щелкнуть на нужных изображениях. Это гораздо быстрее, чем сохранять отдельные файлы, но, как вы понимаете, все равно довольно трудоемко.

Расширений для браузеров существует великое множество, и если вы видели одно, то видели их все. Нужно только найти такое расширение, которое будет работать в вашем браузере, будь то Firefox, Chrome или... (а кто-нибудь использует что-нибудь еще?).

Вот несколько наиболее понравившихся:

- Click Image Downloader

- Дважды щелкните на программе Image Downloader

- Loadify

Экстракторы изображений.

Экстракторы изображений похожи на тракторы, собирающие урожай. Это ленивая метафора (не считая того, что в ней восемь одинаковых букв), но эти программы облегчают работу с изображениями. Обычно достаточно загрузить URL-адрес, и можно мгновенно перебрать все изображения на странице.

Этот метод сбора изображений из Интернета подходит только для небольших проектов, поскольку за один раз можно соскрести только один сайт.

You can find image extractors specific for Reddit, Youtube, or Twitch like SocialSnapper, or try out a more general extraction software like Image Cyborg or Unsplash Bulk Downloader.

Инструменты веб-скрапинга.

Хорошо. Это самые мощные программы. Не покладая рук, соскабливайте тысячи изображений и любую другую информацию с сотен веб-страниц.

Web scraping tools is an umbrella term for all kinds of data collection automation [software] that crawls, scrapes, analyzes, formats, and stores web data. You can do it yourself on a headless browser–using open-source scripts in your command prompt–or opt for web scraping APIs that simplify the process, presenting quick commands on a graphical user interface(GUI).

If you have programming skills, the Python library is a favorite. However, there are drawbacks to doing it yourself.

- Технические проблемы: При работе с веб-сайтами многое может пойти не так. Если вы не знакомы с используемыми программами и скриптами, поиск и устранение неисправностей может отнять у вас много времени.

- Legal issues: Web scraping is legal, but there are cases (like real ones in courtrooms) where the prosecution wins claims of privacy infringement or scraping negligence that lead to property damage.

- Качество данных (или его отсутствие): Возможно, вы даже не знаете, чем отличаются данные хорошего и плохого качества. Но если у вас нет опыта работы с веб-скрапингом, есть вероятность, что качество данных нуждается в улучшении.

- Неэффективно: Если вы не знаете, что делаете, то сначала потребуется время, чтобы разобраться в этом. Затем, когда вы начнете работать, вам придется разбираться во всем остальном. Если заниматься этим годами, то можно приблизиться к тому, чтобы делать это эффективно.

- Дороговизна: Самостоятельная работа может показаться наиболее доступным вариантом, и если вы занимаетесь веб-скрапингом в качестве хобби, то так оно и есть. С другой стороны, если веб-скрапинг - это расходы для бизнеса, то вы выгоднее потратите время, воспользовавшись услугами профессионалов.

Our two most significant recommendations are Octoparse and Parsehub because they have free plans and tons of tutorials to build your scraping skillset. With both, you can quickly learn how to use their software efficiently and economically. All you have to do is download their software and follow their on-ramping tutorial.

Упрощение работы с изображениями с помощью прокси-серверов.

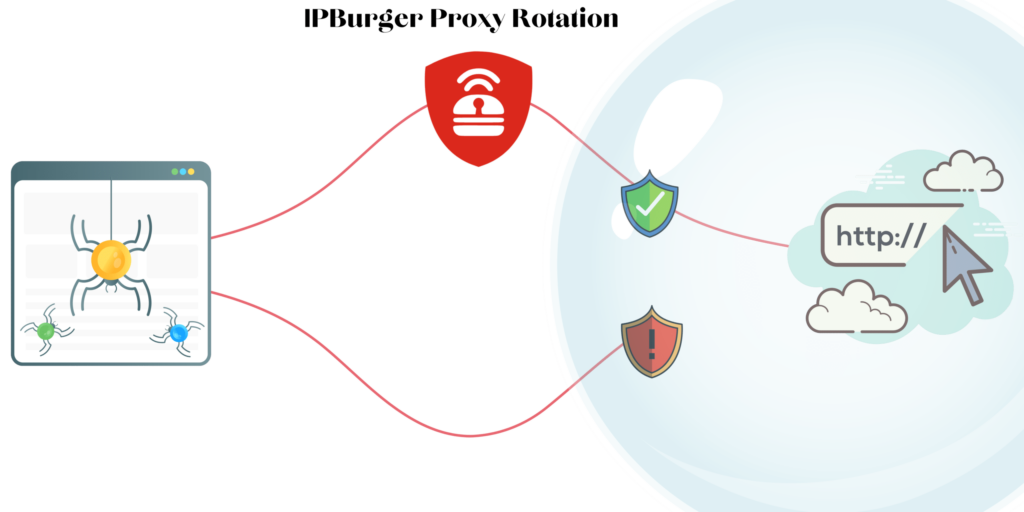

Наиболее распространенная проблема, связанная со сбором изображений, - это когда сайты принимают вас за хакера или другую вредоносную организацию. Это происходит потому, что веб-скрапинг может выглядеть как атака, если вы посылаете слишком много последовательных запросов с одного и того же IP-адреса.

So to pacify website security, you’ll want to send requests to the URL from hundreds of different IP addresses. To do this, you employ rotating residential proxies, which make it seem like ordinary users are sending requests instead of one busy-body riddling their website with thousands of requests per second.

Они легко настраиваются с помощью интуитивно понятного менеджера прокси IPBurger. Достаточно задать параметры - местоположение, интернет-провайдера и веб-протокол - и затем сформировать список прокси из более чем 75 млн. IP-адресов жилых домов. Затем нужно подключить прокси к веб-скраперу, и все.

Нужны ли прокси-серверы для простого скрепера изображений?

Not in the way you need them for more robust web scrapers, but there are many other use cases for high-quality residential proxies.

И если однажды вы решите масштабировать свои усилия по сбору данных, а экстракторы изображений окажутся не по зубам, вы будете готовы к бесперебойной работе с веб-приложениями.