Fatigué du copier-coller ? Découvrez les méthodes les plus simples pour récupérer des images sur le web.

Maintenant, si vous voulez juste un économiseur d'écran ou une image de fond, le web scraping peut être excessif. Mais c'est une compétence qui s'applique à bien d'autres choses. Alors, restez dans les parages.

Nous commencerons par les extensions de navigateur, nous examinerons les extracteurs d'images, puis nous aborderons les outils d'exploration du web.

Qu'est-ce que le scraping d'images ?

Le scraping d'images consiste simplement à prendre l'URL d'une image sur un site web et à l'enregistrer dans une base de données pour l'utiliser ultérieurement.

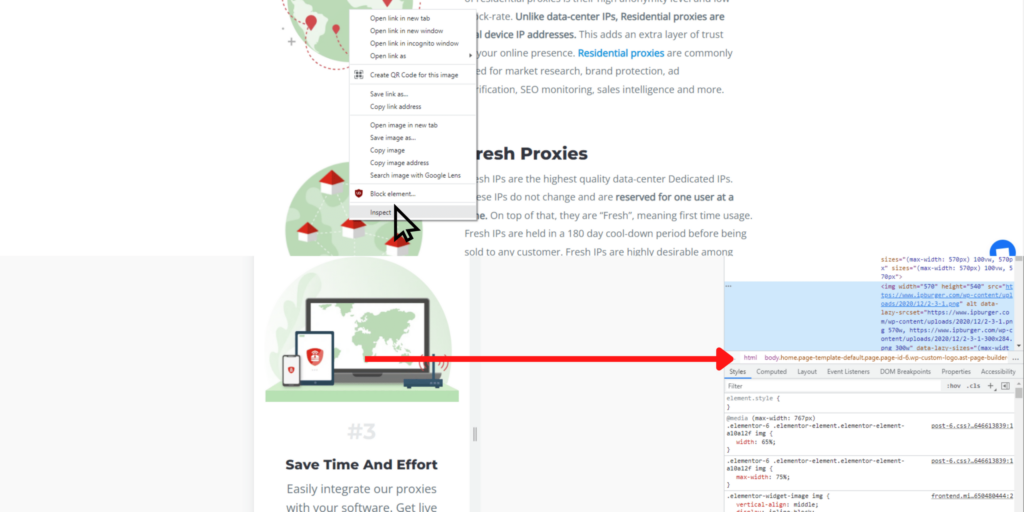

Par exemple, si vous souhaitez enregistrer les images publicitaires d'une page web, il vous suffit de copier-coller le code HTML du site web dans une feuille de calcul. Pour ce faire, il vous suffit de faire un clic droit sur l'image et de cliquer sur Inspecter. Si vous utilisez Chrome, vous pouvez voir les outils de développement apparaître et se concentrer sur la ligne HTML de l'image.

L'automatisation de ce processus est ce que la plupart des gens appellent le scraping d'images.

Pourquoi automatiser le scraping d'images ?

Lorsque vous avez besoin de récupérer quelques images d'un site web auquel vous n'avez pas accès en tant qu'administrateur, vous pouvez simplement "enregistrer sous" l'image en question, et vous aurez les fichiers sur votre ordinateur.

Cependant, si vous avez besoin de centaines ou de milliers d'images provenant de plusieurs URL, "enregistrer sous" est une perte de temps. C'est là que le scraping d'images entre en jeu. Au lieu de cliquer sans cesse sur les mêmes boutons, vous pouvez utiliser des scripts pour automatiser le processus et réduire les milliers de clics à quelques uns seulement.

Types d'extracteurs de données web d'images.

Il existe plusieurs façons de récupérer des images. Même si elles sont toutes plus rapides et plus faciles à mettre en œuvre que l'enregistrement manuel de chaque image, une à une, sur votre ordinateur, elles fonctionnent différemment les unes des autres.

Il nous faut donc commencer par définir chaque type de méthode de raclage.

Extensions de navigateur.

Avec les extensions de navigateur, vous devez installer le plugin et cliquer sur les images que vous souhaitez. C'est beaucoup plus rapide que d'enregistrer des fichiers individuels, mais cela reste assez fastidieux, comme vous pouvez l'imaginer.

Les extensions de navigateur sont légion, et si vous en avez vu une, vous les avez toutes vues. Il suffit de trouver une extension qui fonctionne avec votre navigateur, qu'il s'agisse de Firefox, de Chrome ou... (quelqu'un utilise-t-il autre chose ?).

Voici quelques exemples :

- Click Image Downloader

- Double-cliquez sur Image Downloader

- Loadify

Extracteurs d'images.

Les extracteurs d'images sont comme des tracteurs qui récoltent des images. Il s'agit d'une métaphore paresseuse (à part le fait qu'elle comporte huit lettres identiques), mais ces programmes facilitent le chargement des images. En général, il suffit de charger l'URL pour récupérer instantanément toutes les images de la page.

Cette méthode de collecte d'images sur le web n'est adaptée qu'aux petits projets, car elle ne permet de récupérer qu'un seul site à la fois.

You can find image extractors specific for Reddit, Youtube, or Twitch like SocialSnapper, or try out a more general extraction software like Image Cyborg or Unsplash Bulk Downloader.

Outils d'exploration du Web.

D'accord. Ce sont les gros bras. Récupérez des milliers d'images - et n'importe quoi d'autre - à partir de centaines de pages web sans la moindre difficulté.

Web scraping tools is an umbrella term for all kinds of data collection automation [software] that crawls, scrapes, analyzes, formats, and stores web data. You can do it yourself on a headless browser–using open-source scripts in your command prompt–or opt for web scraping APIs that simplify the process, presenting quick commands on a graphical user interface(GUI).

If you have programming skills, the Python library is a favorite. However, there are drawbacks to doing it yourself.

- Problèmes techniques : Beaucoup de choses peuvent mal tourner lorsque vous scrappez des sites web. Si vous ne connaissez pas bien les programmes et les scripts que vous utilisez, le dépannage peut prendre beaucoup de temps.

- Legal issues: Web scraping is legal, but there are cases (like real ones in courtrooms) where the prosecution wins claims of privacy infringement or scraping negligence that lead to property damage.

- Qualité des données (ou absence de qualité) : Vous n'êtes peut-être même pas conscient de la différence entre des données de bonne et de mauvaise qualité. Mais si vous n'avez pas d'expérience dans le domaine du web scraping, il y a de fortes chances que la qualité des données ait besoin d'être améliorée.

- Inefficace : Si vous ne savez pas ce que vous faites, il vous faudra d'abord du temps pour le découvrir. Ensuite, une fois que vous aurez commencé, vous devrez vous occuper de tout le reste. Après avoir travaillé pendant des années, il se peut que vous soyez proche de l'efficacité.

- Coût : Le faire soi-même ou en interne peut sembler être l'option la plus abordable, et si vous ne faites du scraping que par hobby, cela peut être le cas. En revanche, si le web scraping représente un coût pour l'entreprise, il est plus rentable de faire appel à un service professionnel.

Our two most significant recommendations are Octoparse and Parsehub because they have free plans and tons of tutorials to build your scraping skillset. With both, you can quickly learn how to use their software efficiently and economically. All you have to do is download their software and follow their on-ramping tutorial.

Faciliter le scraping d'images avec des proxies.

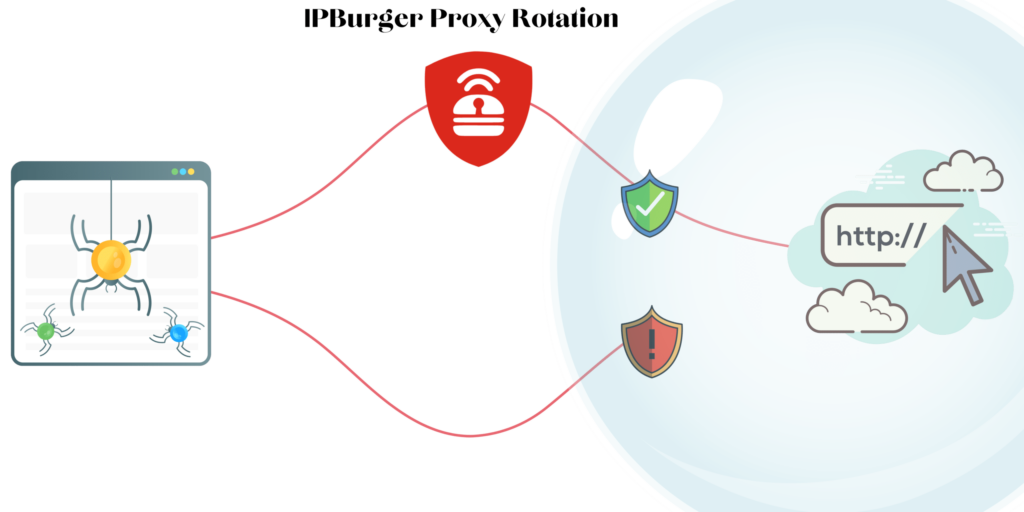

Le problème le plus courant lorsqu'il s'agit de récupérer des images est que les sites web vous confondent avec un pirate informatique ou une autre entité malveillante. En effet, le web scraping peut ressembler à une attaque si vous envoyez trop de requêtes consécutives à partir de la même adresse IP.

So to pacify website security, you’ll want to send requests to the URL from hundreds of different IP addresses. To do this, you employ rotating residential proxies, which make it seem like ordinary users are sending requests instead of one busy-body riddling their website with thousands of requests per second.

Ils sont faciles à mettre en place grâce au gestionnaire de proxy intuitif d'IPBurger. Il vous suffit de définir vos paramètres (emplacement, fournisseur d'accès à Internet et protocole Web), puis de générer une liste de serveurs proxies à partir de plus de 75 millions d'adresses IP résidentielles. Il vous suffit ensuite de connecter les proxys au scraper web, et le tour est joué.

Avez-vous besoin de proxies pour un simple scraper d'images ?

Not in the way you need them for more robust web scrapers, but there are many other use cases for high-quality residential proxies.

Et si vous décidez un jour d'intensifier vos efforts de collecte de données et que les extracteurs d'images ne suffisent plus, vous êtes paré pour un scraping Web ininterrompu.