Вы не программист и не хотите платить за сбор данных — довольно затруднительное положение. Но давайте посмотрим, подойдут ли вам какие-либо из этих бесплатных инструментов для сбора данных.

Мы не можем позволить себе не информировать наш бизнес с помощью данных.

И не просто данные.

Такого, который смягчает хватку неопределенности при принятии решений.

Вы все еще не уверены в том, что ничего не вкладываете в свою стратегию сбора данных?

Be our guest–this guide does its best to recommend free web scraping tools that you can use to collect and analyze data without prior programming knowledge.

Что такое веб-скрапинг?

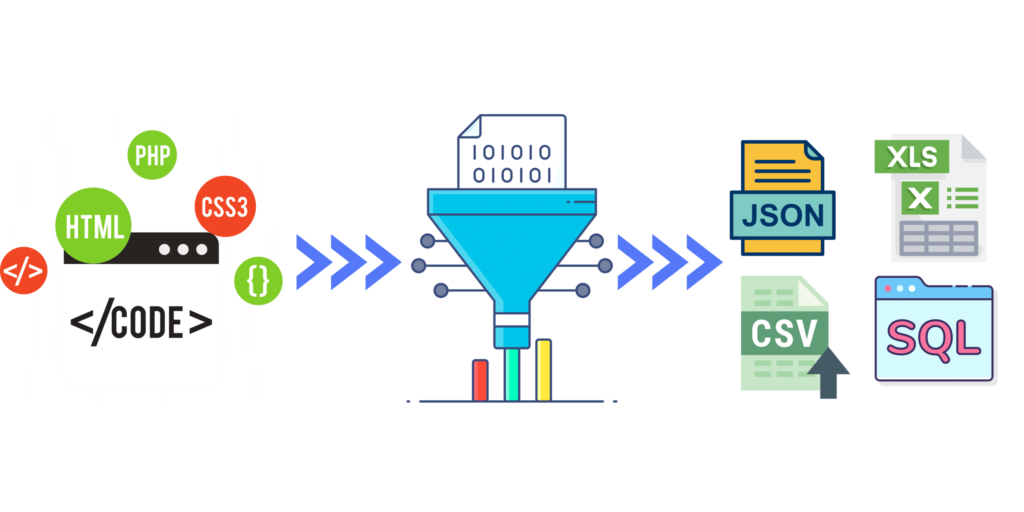

Web scraping is the automated gathering of online data from web pages. We then process the scraped data for extracting market insights, displaying information, and developing artificial intelligence.

Как работает веб-скрапинг?

Сначала скрипт или кодированная программа, которую мы называем ботом для веб-скрапинга, просматривает целевой URL-адрес, как это сделал бы человек. Затем он посылает на эту веб-страницу запросы на получение конкретной информации, которую мы заранее намечаем, и получает пакет в виде неструктурированных данных.

Далее инструмент веб-скрапинга анализирует данные, превращая их в структурированную структуру, легко читаемую человеком.

Наконец, можно загрузить набор данных для дальнейшего анализа, разместить его на сайте или представить партнерам/клиентам.

Как выбрать бесплатный инструмент для веб-скрапинга.

Бесплатные вещи всегда имеют подвох. В случае бесплатных инструментов для веб-скрапинга загвоздка заключается в том, что программа либо имеет ограниченную версию, либо является бесплатной пробной версией, либо для работы с ней необходимы навыки программирования.

Ограниченные версии и бесплатные пробные версии - это "тизеры", призванные побудить вас приобрести полную версию. Тем не менее, иногда они предлагают достаточно кредитов, данных или времени для проведения экспериментов или даже завершения скромного исследовательского проекта.

If you have a computer programming background (what are you even doing here)..you can use free web scraping frameworks and node libraries to your heart’s content.

Для тех, кто не умеет общаться с компьютерами, рассмотрим, какие бесплатные инструменты для веб-скрапинга доступны непрограммистам.

Типы бесплатных инструментов для веб-скрапинга.

- Расширения для браузеров - этопростые решения для веб-скрапинга, которые можно использовать в большинстве браузеров, таких как Chrome и Safari. Они больше подходят для небольших проектов по скрапбукингу, поскольку позволяют скрапить только одну страницу за раз. Преимущество использования браузерных инструментов для скраппинга заключается в том, что они, как правило, бесплатны и просты в использовании.

- Устанавливаемое программное обеспечение - этозагружаемые программы, которые могут работать с несколькими страницами и идеально подходят для большинства проектов малого и среднего размера. Несмотря на то, что стоимость таких инструментов для веб-скрапинга невелика, они часто требуют более серьезного обучения.

- Облачные API - ониизвестны как API для веб-скрапинга. Они существуют на облачном сервере, принадлежащем и управляемом службой веб-скрапинга. Все, что нужно сделать, - это подписаться на один из их ежемесячных планов и ввести параметры поиска. Часто они поставляются в комплекте с прокси-серверами и не требуют кодирования.

Бесплатные браузерные расширения для веб-скрапинга.

Веб-скрапер

Это отдельное расширение для хрома является совершенно бесплатным и простым в использовании для извлечения веб-данных. С его помощью можно создать и протестировать карту сайта, чтобы понять, как ориентироваться на сайте и какие данные извлекать.

Web-скрепер также имеет облачное расширение, которое позволяет соскребать большие объемы данных, выполнять несколько задач по соскребанию одновременно и экспортировать данные в CSV или сохранять их в облаке.

Скребок

Этот бесплатный инструмент для соскабливания веб-страниц представляет собой расширение chrome для соскабливания простых веб-страниц. Он прост в использовании и позволяет соскребать веб-контент и организовывать результаты в виде электронной таблицы.

Для этого нужно выделить текст, щелкнуть на нем правой кнопкой мыши и выбрать в меню браузера пункт Scrape Similar. В результате вы получите данные и извлечете другое содержимое, добавив новые колонки. Для использования некоторых дополнительных возможностей может потребоваться знание языка XPath.

Скребок данных

Простой в использовании и бесплатный инструмент для извлечения данных с одной страницы в файлы данных CSV и XLS. Data Scraper - это расширение для браузера, которое помогает организовать данные в таблицы. Плагин можно получить в Google.

В бесплатной версии можно соскребать 500 страниц в месяц, что вполне достаточно для небольших исследовательских проектов. Платная версия позволяет собирать гораздо больше страниц и включает такие функции, как API.

Бесплатное загружаемое программное обеспечение для веб-скрапинга.

Octoparse

Octoparse - это интуитивно понятное программное обеспечение, использующее интерфейс "укажи и щелкни" для быстрого выбора полей, которые необходимо соскоблить.

Он работает со статическими и динамическими сайтами, использующими AJAX, JavaScript, cookies и т.д. Возможен экспорт в форматы CSV, HTML, KLSX или TXT.

Бесплатная версия предоставляет десять краулеров, а платные планы имеют дополнительные возможности, например, API, позволяющий собирать больше данных более эффективно.

Scrapy

Этот фреймворк с открытым исходным кодом использует язык Python для создания веб-скраперов. Он предоставляет инструменты для эффективного извлечения данных с веб-сайтов, их обработки и хранения в удобной для вас структуре и формате.

Scrapy - эффективное программное обеспечение для более масштабных планов сбора данных.

Scrapy имеет активное сообщество и множество подробных руководств, что облегчает его изучение и устранение неполадок. Данные можно экспортировать в форматы CSV, XML и JSON.

Parsehub

Этот комплексный инструмент для анализа веб-страниц работает под Windows, Mac и Linux, поддерживает AJAX, JavaScript, перенаправление, cookies и сессии и позволяет просматривать как один, так и несколько сайтов.

Простая и удобная в использовании программа обладает такими расширенными возможностями, как пагинация, бесконечная прокрутка страниц, всплывающие окна и навигация.

Бесплатная версия предоставляет пять проектов с 200 страницами на прогон. Платная подписка позволяет использовать до 20 частных проектов с 10 000 страниц за прогон.

OutWitHub

Эта бесплатная и удобная программа отлично подходит для быстрого извлечения небольших объемов данных из Интернета. Он автоматически просматривает ряд веб-страниц и выполняет задачи извлечения данных.

Для получения данных из Интернета не требуется никаких навыков программирования, их можно экспортировать в JSON, XLSX, SQL, HTML, CSV и т.д.

Бесплатные API для веб-скрапинга.

Мозенда

Mozenda обладает удобным пользовательским интерфейсом. Имеется приложение для создания проектов извлечения данных и веб-консоль для запуска агентов, систематизации результатов и экспорта данных в форматы CSV, XML, JSON или XLSX.

Mozenda подходит для работы с большими и малыми объемами данных, но для ее использования могут потребоваться не только базовые навыки кодирования.

ScrapeStorm

ScrapeStorm имеет бесплатную пробную версию, но для получения всех возможностей необходимо обновить ее. Вы можете собирать данные и организовывать их в различных форматах, включая TXT, CSV, Excel, JSON, MySQL, Google Sheets и т.д.

ScrapeStorm не требует навыков кодирования и использует искусственный интеллект для идентификации данных. Он автоматически определяет изображения, цены, контактные данные, ссылки, формы и списки, а также другие наборы данных.

Check out our blog for a more comprehensive guide on choosing the correct web scraping tools for your data extraction goals. And if you’re ready to scrape, let us help you set up your rotating residential proxies!